type

status

date

slug

summary

tags

category

icon

password

1. Linux安装

在线安装:

yum install -y iperf3

#安装的是iperf3-3.1.7版本

离线安装:

tar -zxvf iperf3.tar.gz

cd iperf3 && rpm -ivh *

2. Windows安装

官网下载安装包:

下载完成后解压,使用时进入cmd终端,cd到解压路径,可以找到iperf3.exe程序即可正常使用

3. 注意事项

软件使用过程中需开通服务所需的安全组策略,默认端口为5210,自己指定端口需另行开放。

三、软件使用

1. Linux系统上使用

1.1 压测自身网卡性能

命令涉及参数含义:

- s 以server服务模式启动

- D 后台运行

- c 指定测试端的IP地址

- t 测试时常,单位为秒

- f 测试结果的单位 (kbits,Mbits,KBytes,MBytes)

- p 可指定端口 默认端口为5201

输出结果参数含义:

Interval:输出结果的时间间隔

Transfer:间隔时间内传输的总流量

Bandwidth:间隔时间内的最大吞吐量

Retr: 重发包数

Cwnd: 拥塞窗口排队数据量大小

分割线下方的数据为单位测试时间内单项数据的总和。

1.2 压测其他主机网络

- 首先要确保目的端测试主机iperf3服务开启

iperf3 -s (前端运行,实时打印数据到屏幕上)

- 本地终端输入命令

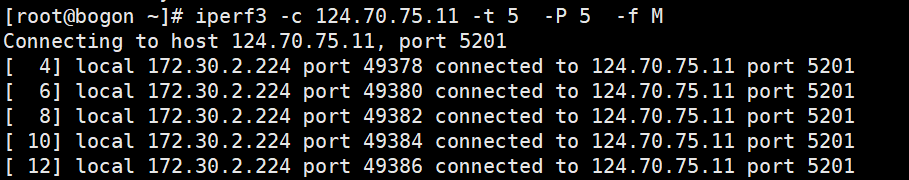

iperf3 -c 124.70.75.11 -t 5 -P 5 -f M

新参数含义:

- P 表示并发数

测试结果示例:

可见 同时建立了5个连接

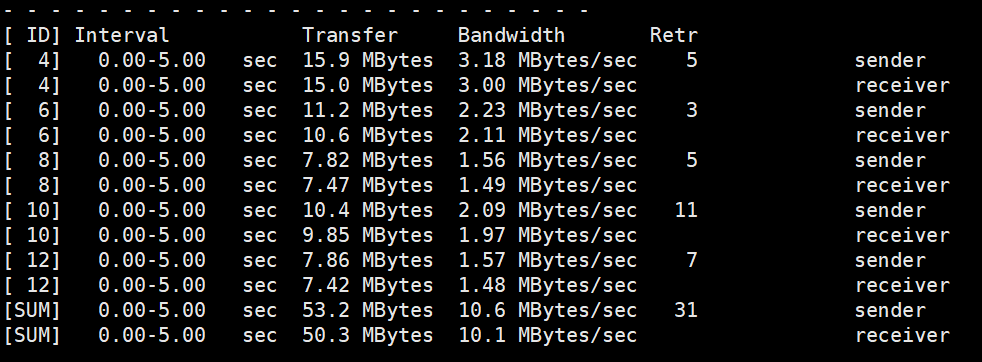

1.2.1 结果分析

结果可见 在五秒钟内共发送了53.2MB数据,接收了50.3MB/s数据,发送最大吞吐量为10.6MB/s,接收最大吞吐量为10.1MB/s,共有31个数据包被重发,没有显示Cwnd参数,说明没有造成网络拥塞,没有达到拥塞窗口的数值。

2. Windows系统上使用

2.1 压测自身网卡性能

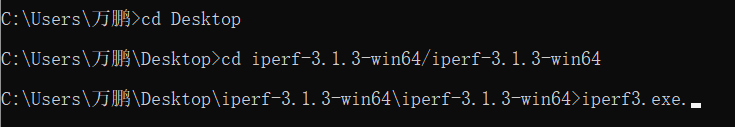

- 首先打开cmd终端,cd切换到iperf3的解压路径下,找到iperf3.exe

- 启动ipers3服务

iperf3.exe -s -D # 后台运行iperf3服务

- 执行测试命令

iperf3.exe -c 127.0.0.1 -f M -t 3 -R

新参数含义:

- R 反向测试(从目的端主机向本地放松数据)

测试结果示例:

无任何丢包,数据包重发现象。

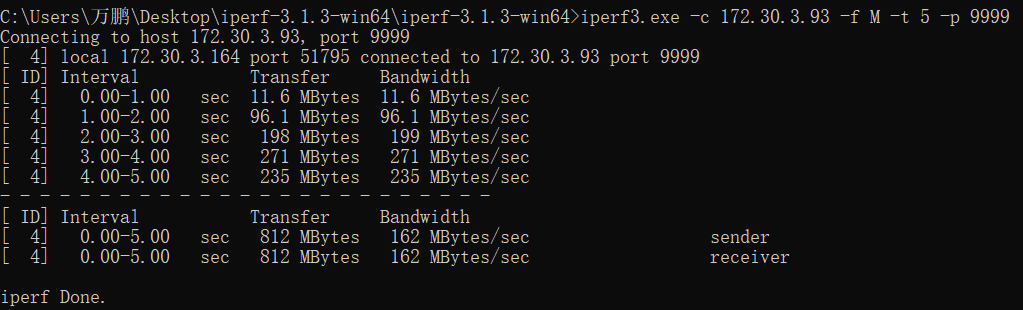

2.2 压测其他不同平台主机网络

本次测试选择不同平台主机,目的端为Linux系统,端口指定为9999,本地为Windows系统,检验能否正常测试。

注意:开通指定端口的安全组策略,Linux主机防火墙上添加放通规则。

- 目的端Linux系统上启动iperf3服务并指定端口9999

iperf3 -s -p 9999

- 本地执行测试命令

iperf3.exe -c 172.30.3.93 -f M -t 5 -p 9999

新参数含义:

- p 指定端口号

测试结果:

测试结果:

无任何重发包和网络阻塞,在测试的5秒钟之内供发送了812M数据,平均每秒吞吐量为162MB/s,一秒钟最大吞吐量为271MB/s,最小为11.6MB/s,并没有达到最大带宽,还可继续增加线程数和测试时间测试。

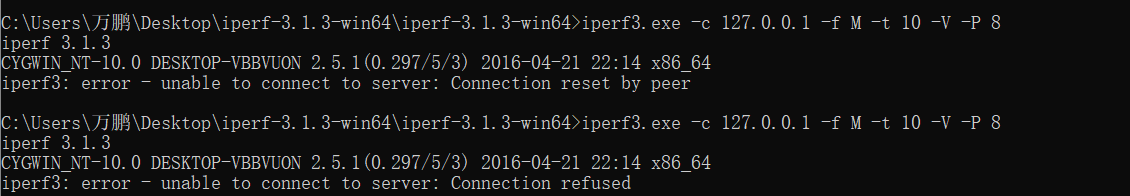

四、测试中遇到的问题

1. iperf3软件崩溃

在一次多线程(50)的测试后,iperf3软件崩溃

具体报错信息如下:

去到任务管理器发现iperf3进程并没有结束,依然存在,并持续占用消耗cpu资源,等待后依旧持续占用,并且无法再正常进行测试,后手动结束进程。

错误复现:

再次进行50线程的测试,结果相同,软件崩溃,并持续占用cpu资源。

解决办法:

将线程数降低至30以下即可正常使用

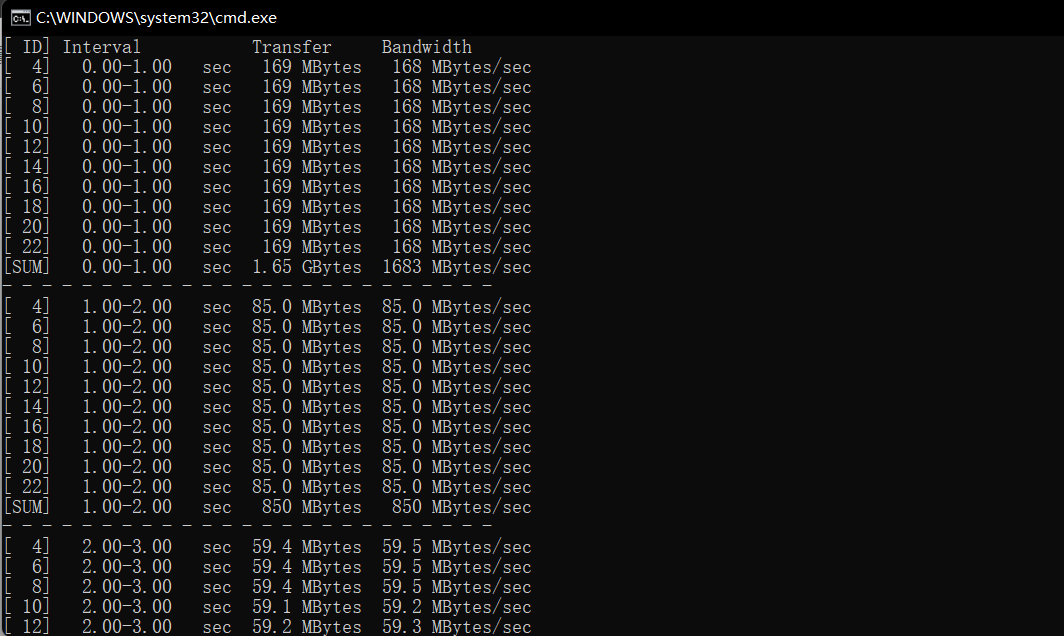

2. Win系统与Linux系统吞吐量差距过大

测试发现本地虚拟机中的Linux系统最大吞吐量和本地物理机(win)系统的最大吞吐量相差巨大。

具体: Linux > Windows

Linux测试最大吞吐量为3193MB,为8个线程并发时结果。

Windows测试最大吞吐量为1447MB,为5个线程并发时结果。

且win平台测试过程中最大吞吐量数值浮动巨大:

暂未找到原因。

五、详细参数:

- Author:NotionNext

- URL:https://tangly1024.com/article/11140ef0-3786-809b-a1e4-ecd072ecff03

- Copyright:All articles in this blog, except for special statements, adopt BY-NC-SA agreement. Please indicate the source!

Relate Posts